NUEVO¡Ahora puedes escuchar artículos de Fox News!

Cuando alguien pierde la capacidad de hablar debido a una condición neurológica como la ELA, el impacto va mucho más allá de las palabras. Toca cada parte de la vida diaria, desde compartir una broma con la familia hasta simplemente pedir ayuda. Ahora, gracias a un equipo de la Universidad de California, Davis, hay un nuevo sistema de interfaz de computadora cerebral (BCI) que está abriendo una conversación natural en tiempo real para las personas que no pueden hablar. Esta tecnología no se trata solo de convertir pensamientos en texto. En cambio, traduce las señales cerebrales que normalmente controlarían los músculos utilizados para el habla, lo que permite a los usuarios «hablar» e incluso «cantar» a través de una computadora, casi al instante.

Regístrese para mi informe gratuito de Cyberguy

Obtenga mis mejores consejos tecnológicos, alertas de seguridad urgentes y ofertas exclusivas entregadas directamente a su bandeja de entrada. Además, obtendrá acceso instantáneo a mi guía de supervivencia de estafa definitiva, gratis cuando se une a mi Cyberguy.com/newsletter.

Hay un nuevo sistema de interfaz de cerebro (BCI) que abre una conversación natural en tiempo real para las personas que no pueden hablar. (UC Davis)

Discurso en tiempo real a través de señales cerebrales

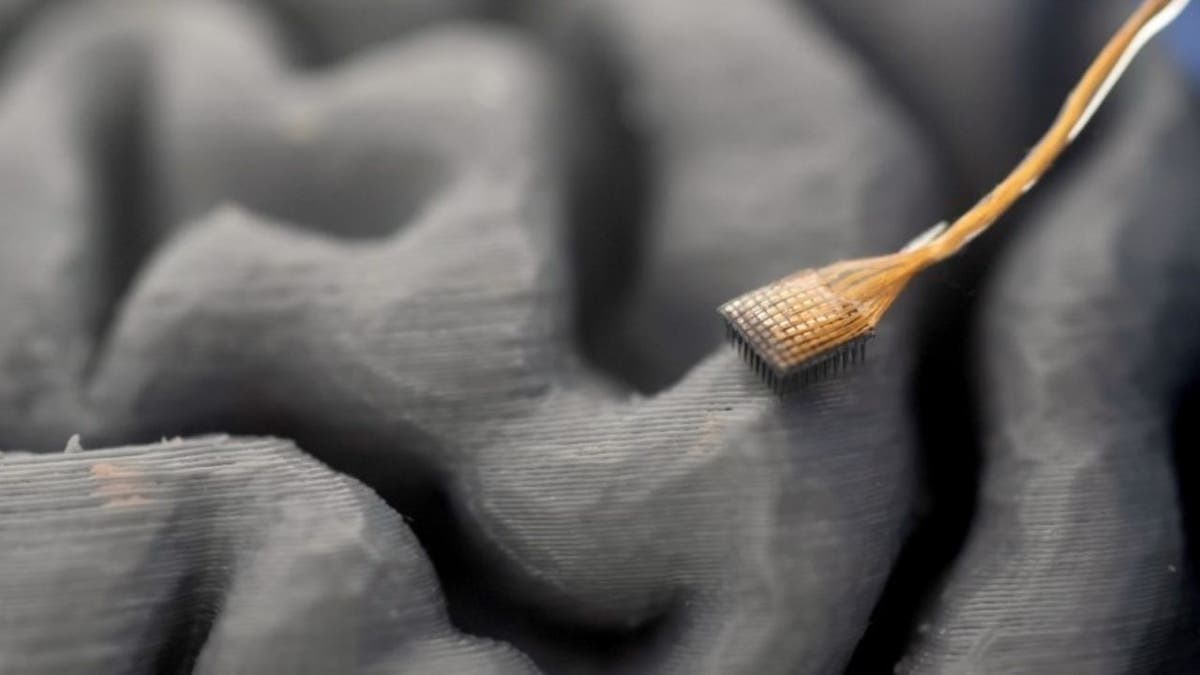

El corazón de este sistema es cuatro matrices de microelectrodos, implantados quirúrgicamente en la parte del cerebro responsable de producir habla. Estos pequeños dispositivos recogen la actividad neuronal que ocurre cuando alguien intenta hablar. Las señales se alimentan a un modelo de decodificación con IA, que las convierte en un discurso audible en solo diez milisegundos. Eso es tan rápido que se siente tan natural como una conversación regular.

Lo que es especialmente notable es que el sistema puede recrear la propia voz del usuario, gracias a un algoritmo de clonación de voz capacitado en grabaciones realizadas antes del inicio de la ELA. Esto significa que la voz digital de la persona suena como ellos, no una voz de computadora genérica. El sistema incluso reconoce cuándo el usuario intenta cantar y puede cambiar el tono para que coincida con melodías simples. También puede darse cuenta de los matices vocales, como hacer una pregunta, enfatizar una palabra o hacer interjecciones como «aah», «ooh» o «hmm». Todo esto se suma a una conversación mucho más expresiva y de sonido humano de lo que las tecnologías anteriores podrían ofrecer.

Traduce las señales cerebrales que normalmente controlarían los músculos utilizados para el habla, lo que permite a los usuarios «hablar» e incluso «cantar» a través de una computadora, casi al instante. (UC Davis)

Cómo funciona la tecnología

El proceso comienza con el participante que intenta hablar oraciones que se muestran en una pantalla. A medida que intentan formar cada palabra, los electrodos capturan los patrones de disparo de cientos de neuronas. La IA aprende a mapear estos patrones a sonidos específicos, reconstruyendo el discurso en tiempo real. Este enfoque permite un control sutil sobre el ritmo y el tono del habla, lo que le da al usuario la capacidad de interrumpir, enfatizar o hacer preguntas al igual que cualquier otra persona.

Uno de los resultados más llamativos del estudio de UC Davis fue que los oyentes podían entender casi el 60 por ciento de las palabras sintetizadas, en comparación con solo el cuatro por ciento sin el BCI. El sistema también manejó nuevas palabras inventadas que no eran parte de sus datos de entrenamiento, mostrando su flexibilidad y adaptabilidad.

La IA aprende a mapear estos patrones a sonidos específicos, reconstruyendo el discurso en tiempo real. (UC Davis)

El impacto en la vida diaria

Poder comunicarse en tiempo real, con la propia voz y personalidad, es un cambio de juego para las personas que viven con parálisis. El equipo de UC Davis señala que esta tecnología permite a los usuarios estar más incluidos en las conversaciones. Pueden interrumpir, responder rápidamente y expresarse con matices. Este es un gran cambio de los sistemas anteriores que solo tradujeron las señales cerebrales en texto, lo que a menudo condujo a intercambios lentos y forzados que se sentían más como enviar mensajes de texto que hablar.

Como David Brandman, el neurocirujano involucrado en el estudio, lo expresó, nuestra voz es una parte central de nuestra identidad. Perderlo es devastador, pero este tipo de tecnología ofrece una verdadera esperanza para restaurar esa parte esencial de quiénes somos.

El equipo de UC Davis señala que esta tecnología permite a los usuarios estar más incluidos en las conversaciones. (UC Davis)

Mirando hacia el futuro: próximos pasos y desafíos

Si bien estos primeros resultados son prometedores, los investigadores se apresuran a señalar que la tecnología aún está en sus primeras etapas. Hasta ahora, solo se ha probado con un participante, por lo que se necesitan más estudios para ver qué tan bien funciona para otros, incluidas las personas con diferentes causas de pérdida del habla, como el accidente cerebrovascular. El ensayo clínico Braingate2 en UC Davis Health continúa inscribiendo a los participantes para refinar y probar aún más el sistema.

La tecnología todavía está en sus primeras etapas. (UC Davis)

Takeaways de Kurt’s Key

Restaurar discurso natural y expresivo a las personas que han perdido sus voces es uno de los avances más significativos en la tecnología de interfaz de la computadora cerebral. Este nuevo sistema de UC Davis muestra que es posible traer una conversación personal en tiempo real a la vida de los afectados por la parálisis. Si bien todavía hay trabajo por hacer, el progreso hasta ahora es dar a las personas la oportunidad de volver a conectarse con sus seres queridos y el mundo que los rodea de una manera que realmente se siente como la suya.

A medida que las interfaces de la computadora cerebral se vuelven más avanzadas, ¿dónde deberíamos trazar la línea entre mejorar las vidas y alterar la esencia de la interacción humana? Háganos saber escribiéndonos en Cyberguy.com/contact.

Regístrese para mi informe gratuito de Cyberguy

Obtenga mis mejores consejos tecnológicos, alertas de seguridad urgentes y ofertas exclusivas entregadas directamente a su bandeja de entrada. Además, obtendrá acceso instantáneo a mi guía de supervivencia de estafa definitiva, gratis cuando se une a mi Cyberguy.com/newsletter.

Copyright 2025 cyberguy.com. Reservados todos los derechos.

Últimas noticias de última hora Portal de noticias en línea

Últimas noticias de última hora Portal de noticias en línea