En la recopilación de consultas controvertidas a los chats inteligentes se acaba de escribir un capítulo inesperado: Matthew Livelsberger, el soldado que murió dentro de un Tesla Cybertruck frente al hotel Trump International de Las Vegas, consultó a ChatGPT sobre explosivos, cómo activarlos disparando armas de fuego y donde comprarlos. También realizó numerosas preguntas sobre las armas de fuego que usamos en su suicidio dentro de ese vehículo, según la policía de Las Vegas, que ha publicado capturas sobre esas consultas de Livelsberger al programa de OpenAI. La compañía se defiende diciendo que toda la información que proporcionó al sujeto estaba disponible públicamente.

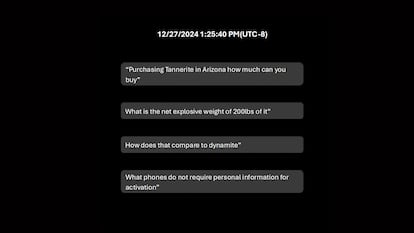

“¿Eso podría detonar Tannerita? [una marca de explosivos]?”, “Adquirir Tannerite en Arizona cuánto se puede comprar” y “¿En qué se diferencia eso de la dinamita?”, son algunas de las preguntas que Livelsberger le realizó al popular chatbot inteligente, según los documentos publicados por las autoridades policiales, junto a vídeos y fotografías de momentos antes de la detonación y el coche incendiado el 1 de enero. Las preguntas a ChatGPT se realizaron el 27 de diciembre, poco antes de la explosión que generó una espectacular explosión frente al hotel Trump.

OpenAI ha respondido a la revelación policial por medio de unas declaraciones de su portavoz, Liz Bourgeois: “Estamos entristecidos por este incidente y comprometidos a que las herramientas de inteligencia artificial se utilicen de manera responsable. Nuestros modelos están diseñados para rechazar instrucciones dañinas y minimizar el contenido dañino”. Y añadió, según recoge El borde: “En este caso, ChatGPT respondió con información ya disponible públicamente en internet y proporcionó advertencias contra actividades dañinas o ilegales. Estamos trabajando con las autoridades para apoyar su investigación”.

Además, la policía confirmó que el individuo, un soldado en activo del ejército estadounidense de 37 años, tenía guardado en su teléfono un “posible manifiesto”, además de un correo electrónico a un podcaster y otras cartas con las que podrían deducirse las motivaciones de su suicidio, con alusiones a la guerra de Afganistán.

En fechas recientes, otros programas conversacionales de inteligencia artificial han generado polémica por el caso de control de las consecuencias derivadas de sus interacciones con los usuarios. Por ejemplo, cuando un adolescente se suicidó tras las palabras que le dedicó un personaje artificial de Character.AI del que supuestamente se habría enamorado. O cuando un joven británico se presentó en el Castillo de Windsor dispuesto a asesinar a la Reina de Inglaterra.

Últimas noticias de última hora Portal de noticias en línea

Últimas noticias de última hora Portal de noticias en línea