La inteligencia artificial está pecando de soberbia. No es que lo esté haciendo adrede, porque no piensa ni razón, pero los algoritmos que le dan cuerda a herramientas como ChatGPT o DALL-E están calibrados de tal manera que, cuando se les hace un pedido o se les plantea una pregunta, terminan arrojando respuestas muy detalladas aunque no tengan una base clara para generarlas. “Exceso de confianza”, ese es el diagnóstico de Pablo Martínez Olmos (Granada, 40 años), un doctor en Ingeniería de Telecomunicaciones que plantea el desarrollo de una inteligencia artificial “humilde”, capaz de declarar el nivel de incertidumbre sobre los resultados que arroja.

“Me gustó la idea de humilde porque nosotros pensamos que una persona con esta virtud es alguien consciente de sus limitaciones y se frena a la hora de responder cuando no tiene idea de un tema”, dice Martínez, sentado en su despacho en el Departamento de Teoría de la Señal y Comunicaciones de la Universidad Carlos III de Madrid. El ingeniero acaba de ser reconocido con una de las Becas Leonardo que la Fundación BBVA entrega para impulsar “proyectos innovadores” en áreas de la ciencia y la cultura. La humildad es, por lo tanto, saber no dar una solución muy detallada ni muy elaborada cuando realmente no se conoce su respuesta. Algo en lo que la inteligencia artificial está fallando.

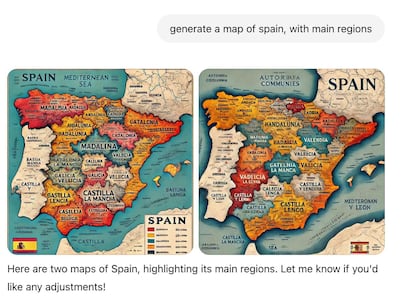

Alcanza con pedirle a DALL-E —el programa de inteligencia artificial de OpenIA que crea imágenes a partir de descripciones textuales— que genere un mapa detallado de España para que este sesgo quede en evidencia. Martínez lo ha probado. “La forma del país está bien captada, pero luego el mapa incluye aspectos muy pormenorizados de la geografía, como montañas, ríos o nombres de regiones, que son totalmente falsos”, apunta. Luego, agrega: “Los algoritmos están entrenados con ciertos sesgos de diseño que los llevan a cometer lo que llamamos alucinacionessalidas muy detalladas que no tienen ninguna base real”. estas alucinaciones hacen que, ante un mismo pedido, en este caso, un mapa de España, la herramienta genere resultados muy distintos. “Aisladamente, cada mapa parece tener sentido, porque están construidos de forma muy fina, pero si se los observa bien están plagados de errores”.

Esto acarrea varios problemas. Uno de ellos es la falta de rigor en las soluciones que ofrece la IA. Otro, que las herramientas generativas están más expuestas a un uso malintencionado. Los algoritmos en estas plataformas cuentan con varios mecanismos de control para limitar algunas respuestas que puedan dar información potencialmente peligrosa o privada, como las instrucciones para fabricar un explosivo casero. Sin embargo, Martínez detalla que “el corazón del algoritmo sigue siendo poco confiable cuando se trata de alucinaciones y, por lo tanto, es muy confiado en el nivel de detalle de sus respuestas”. Funciona igual que con las personas: cuanta más confianza tenga en sí un algoritmo, más fácil será encontrarle “las cosquillas y engañarlo”. Si se lo preguntas directamente no te lo dirás, pero, con un poco de maña, ChatGPT puede terminar explicando cómo cocinar metanfetaminas en casa.

Reformular los algoritmos

Martínez apunta que su línea de investigación hacia una inteligencia artificial humilde se basa en pensar cómo reformular los algoritmos para restringir esa capacidad de dar soluciones arbitrariamente detalladas y que no se basan en información confiable. El objetivo final es volverla más útil, confiable y segura. Lograrlo implica varios retos computacionales. “Una de las ideas que proponemos es hacerle la vida más complicada a la red neuronal durante su entrenamiento, utilizando ataques malintencionados y contradictorios”, apunta. También lo es aumentar las restricciones que el algoritmo tiene para almacenar toda la información en la que basa sus respuestas para que haya “cierto orden”.

Martínez pone como ejemplo el cuarto de juguetes de un niño pequeño. Allí conviven caóticamente piezas de Legos, muñecos de acción, pinturas y barajas de cartas. Una simple vista todo está desperdigado por la habitación sin ningún criterio, pero el niño, con una gran capacidad para recordar detalles, sabe perfectamente dónde está cada cosa, por lo que cuando quiera armar un rompecabezas en particular, sabrá a dónde ir a buscar las piezas. Solo que también, por el desorden, utilizará partes de otros juegos que, en esta ocasión, no tendrán sentido para el rompecabezas que quiere armar. Sin embargo, si cada juego se guardara en una cajonera o estuche concreto, sería menos probable que se cuelen elementos de otros juegos. Con la información que almacenan los algoritmos sucede igual, hace falta un poco de orden para acortar el margen de error. Al igual que es complicado educar a un niño para que mantenga esta estructura, con la red neuronal de una inteligencia artificial generativa ocurre algo similar en términos computacionales y matemáticos.

El ingeniero sabe que no puede competir con el desarrollo de las grandes compañías tecnológicas, pero su proyecto intenta proponer una metodología de entrenamiento de algoritmos más robusta, que derive en el desarrollo de herramientas más confiables. Aunque ninguna solución es mágica. “La palabra ‘inteligencia’ en todo esto es muy confusa. A mí me gusta más hablar de funciones matemáticas que estamos interpolando y que, por ahora, no pueden prescindir de la capacidad crítica o la supervisión del ser humano”, dice.

Esta idea de una inteligencia artificial humilde, segura, trazable y controlada tendría, cree Martínez, una aplicación concreta en el ámbito médico. Detectar biomarcadores desconocidos, diseñar efectos terapéuticos personalizados, disminuir las consecuencias negativas de ciertos tratamientos y mejorar la calidad de vida de las personas son algunos de los usos potenciales que el diseño de los algoritmos podrían tener si fueran un poco más humildes.

Última hora Portal de noticias 24/7

Última hora Portal de noticias 24/7

/cdn.vox-cdn.com/uploads/chorus_asset/file/25716336/2401_main_murata.jpg?w=310&resize=310,165&ssl=1)

Comments are closed.